Open-Source vs. Closed AI: Who Should You Trust?

July 08, 2025

Theo: https://www.index.dev/blog/open-source-vs-closed-ai-guide

Bài được đưa lên Internet ngày: 08/07/2025

Niềm tin phụ thuộc vào mục tiêu của bạn: các mô hình đóng dẫn đầu về hiệu suất và khả năng kiểm soát, trong khi các mô hình mở chiến thắng về tính minh bạch và tính linh hoạt. Khám phá phương pháp nào mang lại sự tin cậy, bảo mật và hiệu suất tốt nhất.

AI đang biến đổi mọi ngành, nhưng việc tin tưởng vào đúng mô hình là rất quan trọng. Rủi ro rất cao: niềm tin, quản trị, hiệu suất, đạo đức và bảo mật đều đang bị đe dọa.

Các mô hình nguồn đóng (ví dụ: GPT-4, Claude) hiện đang dẫn đầu về hiệu suất thô và khả năng kiểm soát an toàn tập trung.

Các mô hình nguồn mở (ví dụ: Llama 2, Mistral) nổi bật về tính minh bạch, khả năng tùy chỉnh và sự kiểm duyệt của cộng đồng.

Các điểm chuẩn gần đây cho thấy trung bình nguồn đóng vẫn vượt trội, nhưng nguồn mở đang nhanh chóng thu hẹp khoảng cách. Các chuyên gia bảo mật cảnh báo các mô hình mở có nguy cơ bị tấn công dễ dàng hơn do trọng số công khai, tuy nhiên tính minh bạch của chúng giúp đẩy nhanh việc sửa lỗi, trong khi các mô hình đóng che giấu các lỗ hổng nhưng lại dựa vào sự tin tưởng của nhà cung cấp để vá lỗi.

Các khảo sát đối với các nhà phát triển củng cố cuộc tranh luận này: các kỹ sư trẻ và mới vào nghề đặc biệt coi trọng tính minh bạch. Trên thực tế, một khảo sát của StackOverflow năm 2025 cho thấy "niềm tin và khả năng học hỏi đóng vai trò trung tâm trong tương tác của các nhà phát triển trẻ với AI nguồn mở".

Các phòng thí nghiệm AI lớn cũng phản ánh sự phân chia này: OpenAI giữ các mô hình chủ lực của mình sau các khu vườn API khép kín để đảm bảo an toàn, trong khi các công ty như Meta và Anthropic đã mở mã nguồn nhiều mô hình. Ngay cả các nhà hoạch định chính sách cũng đang chú ý đến Đạo luật AI của EU, trong đó nêu rõ nguồn mở là hàng hóa công cộng (Public Good).

Trong bài viết này, chúng ta sẽ đi sâu vào cuộc tranh luận về AI mở và AI đóng. Chúng tôi sẽ giải thích ý nghĩa của từng phương pháp, ai ủng hộ phương pháp nào, tại sao sự tin cậy lại quan trọng, khi nào và ở đâu là phù hợp, và chúng so sánh như thế nào trên các mặt trận chính. Trong quá trình này, chúng tôi sẽ xem xét các tiêu chuẩn hiệu suất, sự đánh đổi về bảo mật, các cân nhắc về đạo đức, cũng như các tác động về quản trị và chính sách.

Cuối cùng, bạn sẽ có một cái nhìn rõ ràng, được chứng minh bằng bằng chứng về mô hình nào (và thực tiễn phát triển nào) tạo nên sự tin cậy trong bối cảnh nào.

Đối tượng tham gia: Nhà phát triển, Công ty và Cộng đồng

Ai đang định hình cuộc tranh luận này? Một bên là cộng đồng nguồn mở và các nhà phát triển độc lập. Cuộc tranh luận đặt cộng đồng nguồn mở (các nhà phát triển đằng sau PyTorch, TensorFlow, Hugging Face và vô số dự án GitHub) đối đầu với các công ty AI giữ bản quyền các mô hình mới nhất của họ để kiểm soát và bảo vệ quyền sở hữu trí tuệ (IP).

Những người ủng hộ công nghệ mở, 82% trong số họ đã đóng góp cho công nghệ nguồn mở, đề cao tính minh bạch, đánh giá ngang hàng và chia sẻ đổi mới. Trong khi đó, các doanh nghiệp và cơ quan quản lý dựa vào các giải pháp nguồn đóng (ví dụ: Azure OpenAI) để đáp ứng các yêu cầu tuân thủ nghiêm ngặt trong các lĩnh vực như chăm sóc sức khỏe và tài chính. Tại các hội nghị và trên các nền tảng chính sách, các chuyên gia tranh luận về "hợp tác mở so với kiểm soát đóng" như một sự phân chia cơ bản trong chiến lược AI.

Các chính phủ cũng tham gia: Đạo luật AI năm 2023 của EU nêu bật lợi ích kinh tế của các mô hình nền tảng nguồn mở trong khi vẫn nhấn mạnh tính an toàn, và các chính sách của Hoa Kỳ và Trung Quốc cũng tranh luận tương tự về tính mở so với kiểm soát. Tuy nhiên, những ranh giới này đang mờ dần khi Sam Altman của OpenAI đã lưu ý đến giới hạn của tính bảo mật hoàn toàn, và bản phát hành Llama 2 của Meta nhấn mạnh sự hợp tác trên toàn ngành.

AI nguồn mở và AI nguồn đóng là gì?

Chúng ta hiểu thế nào về "AI nguồn mở" so với "AI nguồn đóng"? Trên thực tế, các mô hình AI nguồn mở là những mô hình có mã, trọng số mô hình và dữ liệu đào tạo được công bố theo các giấy phép cho phép (MIT, Apache, GPL, v.v.) để mọi người có thể sử dụng và thay đổi. Hãy xem xét các dự án như LLaMA (Meta models) hoặc Stable Diffusion.

Chúng tồn tại trên các nền tảng như Hugging Face hoặc GitHub, và một cộng đồng tình nguyện viên có thể kiểm tra và cải thiện chúng.

Lời hứa chính: minh bạch hoàn toàn. Bạn có thể xem xét kiến trúc, dữ liệu đào tạo (nếu được công bố) và tinh chỉnh mô hình.

Ngược lại, các mô hình AI nguồn đóng là các hệ thống độc quyền, thường chỉ được cung cấp thông qua API hoặc giấy phép thương mại. Các công ty giữ trọng số và mã ở chế độ nền. Bạn có thể sử dụng chúng thông qua các dịch vụ hoặc sản phẩm đám mây (ví dụ: ChatGPT, Bard, Azure Cognitive Services). Hoạt động bên trong không nhìn thấy được và các điều khoản sử dụng được nhà cung cấp cố định. Sự đánh đổi nằm ở khả năng kiểm soát: các nhà cung cấp cho biết các mô hình đóng cho phép họ thực thi chính sách, sửa lỗi tập trung và kiếm tiền dễ dàng hơn.

Giữa hai thái cực này có các phương pháp tiếp cận kết hợp (lai):

Các mô hình phân tầng

Phát hành có kiểm soát

"Lõi mở" với các tiện ích bổ sung độc quyền

Một số hệ thống (như Llama 2) là mô hình mở với giấy phép hạn chế; một số khác là mô hình mở nhưng yêu cầu khóa API. Các mô hình lai này cố gắng cân bằng giữa tính mở và giám sát.

Nhãn này cũng mở rộng sang các công cụ: nhiều thư viện (PyTorch, Hugging Face Transformers, v.v.) là mã nguồn mở, cho phép AI hoạt động ngay cả với các mô hình đóng. Khi chúng ta nói về "AI mở so với AI đóng", chúng ta thực sự đang hỏi ai có thể xem hoặc thay đổi hoạt động bên trong của mô hình.

Về bản chất, AI nguồn mở = minh bạch và cộng đồng, trong khi AI nguồn đóng = kiểm soát độc quyền.

Mỗi bên tin tưởng các cơ chế khác nhau để đảm bảo AI đáng tin cậy và có đạo đức.

Khám phá 20 dự án nguồn mở trên Github có tác động lớn để đóng góp.

Ưu và nhược điểm của từng phương pháp

Tại sao cuộc tranh luận về niềm tin này lại gay gắt như vậy? Bởi vì các mô hình AI có thể có những tác động sâu sắc (một số không mong muốn) và việc xử lý đòi hỏi sự tự tin vào cách chúng hoạt động.

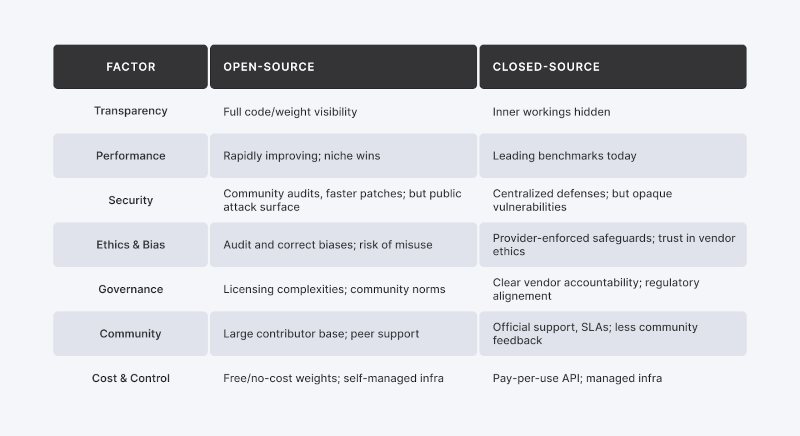

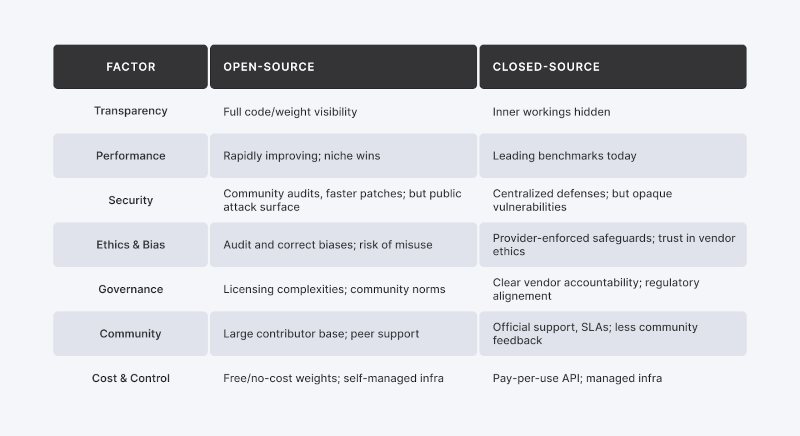

Dưới đây là các yếu tố chính:

Minh bạch so với Bí mật

Các mô hình mở cho phép chúng ta kiểm tra mã, kiểm tra nguồn dữ liệu và kiểm tra các sai lệch, xây dựng sự tin cậy thông qua khả năng hiển thị. Chính sự minh bạch đó làm lộ rõ các lỗ hổng (cửa hậu, rò rỉ dữ liệu). Các mô hình đóng giữ kín các thành phần bên trong, vì vậy chúng ta phải tin tưởng vào các tuyên bố về an toàn và giảm thiểu sai lệch của nhà cung cấp.

Bảo mật

Mã mở mời các chuyên gia bảo mật tìm và sửa lỗi, nhưng điều này cũng đồng nghĩa với việc cung cấp cho kẻ tấn công các bản thiết kế tương tự. Các mô hình đóng ẩn kiến trúc của chúng nhưng dựa vào một vài chuyên gia được chứng nhận và kiểm toán nội bộ. Các nhà cung cấp như OpenAI bổ sung các lớp (ví dụ: "tường lửa AI" kiểm tra lời nhắc) để cân bằng giữa tính minh bạch và khả năng bảo vệ.

Hiệu suất

Các LLM độc quyền (GPT-4, Claude) vẫn đạt điểm chuẩn cao nhất, vì vậy chúng tôi tin tưởng chúng cho các tác vụ có rủi ro cao. Nhưng các mô hình mở như Mistral và Llama-2-70b đang nhanh chóng thu hẹp khoảng cách, và trong các tình huống thích hợp, chúng thậm chí có thể vượt trội hơn các hệ thống đóng.

Đạo đức và Định kiến

Với các mô hình mở, chúng ta có thể xem xét dữ liệu đào tạo và tự áp dụng các bộ lọc đạo đức. Khả năng hiển thị này cũng giúp việc sử dụng sai mục đích (cho mục đích thông tin sai lệch hoặc ngôn từ kích động thù địch) dễ dàng hơn. Các mô hình đóng thực thi các quy tắc một cách tập trung, nhưng chúng ta phải tin tưởng vào các ưu tiên về đạo đức của nhà cung cấp. Một số đề xuất "mở theo tầng" hoặc kiểm toán công khai để đạt được kết quả tốt nhất.

Quản trị

Các cơ quan quản lý phải đối mặt với một thách thức: nếu ai đó có thể sửa đổi một mô hình mở, thì ai sẽ chịu trách nhiệm? Một số bài báo gần đây (ví dụ: Viện R Street) lập luận rằng các cơ quan quản lý phải thích nghi, vì trách nhiệm sản phẩm truyền thống không dễ dàng phù hợp. Đạo luật AI của EU thừa nhận những lợi ích của mã nguồn mở nhưng yêu cầu các rào cản an toàn, trong khi các chính sách của Hoa Kỳ tập trung vào trách nhiệm của nhà cung cấp bất kể trạng thái mã nguồn. Cho dù thông qua các chuẩn mực cộng đồng hay sự tuân thủ của doanh nghiệp, việc quản trị đáng tin cậy là điều cần thiết.

Cộng đồng và Hỗ trợ

Các cộng đồng mã nguồn mở (diễn đàn, GitHub) cung cấp sự hỗ trợ nhanh chóng từ đồng nghiệp và sự đổi mới tập thể khi 57% nhà phát triển thích đóng góp cho các dự án mở. Hệ sinh thái đóng cung cấp các Thỏa thuận Cấp độ Dịch vụ (SLA) chính thức và hỗ trợ từ nhà cung cấp. Các nền tảng như Index.dev kết nối cả hai bằng cách kiểm tra nhân tài, vì vậy chúng ta biết rằng những người có kỹ năng và đáng tin cậy đứng sau mọi hệ thống AI.

Tóm lại, AI nguồn mở có xu hướng chiếm được lòng tin thông qua tính minh bạch, sự hợp tác và giám sát cộng đồng, với cái giá phải trả là dễ bị tổn thương và (cho đến gần đây) hiệu suất thô yếu hơn.

AI nguồn đóng chiếm được lòng tin thông qua kiểm soát tập trung, các biện pháp bảo mật và danh tiếng thương hiệu, nhưng nó đòi hỏi người dùng phải tin tưởng vào các quy trình chưa được biết đến. Cả hai phương pháp đều có ưu và nhược điểm, và các giải pháp thực tế thường kết hợp các yếu tố của từng phương pháp.

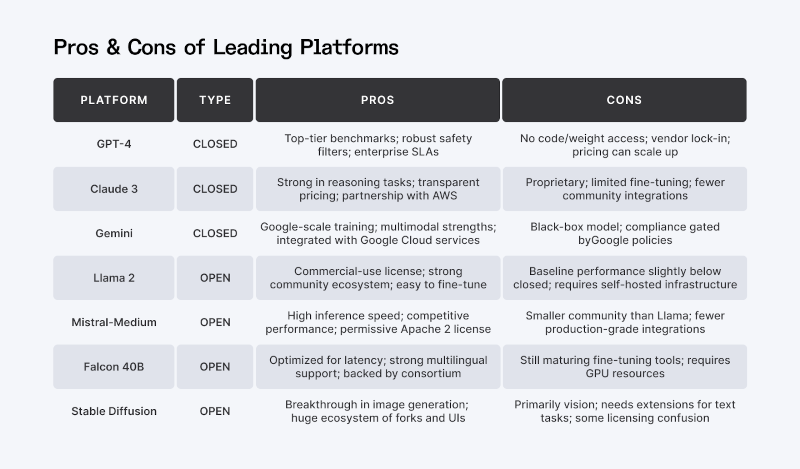

Hiệu suất và Độ tin cậy: So sánh

Hãy cùng tìm hiểu sâu hơn về hiệu suất, một khía cạnh quan trọng tạo nên sự tin tưởng của nhiều người dùng. Nếu một chatbot AI đưa ra những câu trả lời hữu ích một cách đáng tin cậy, người dùng sẽ tin tưởng nó hơn. Các điểm chuẩn gần đây cho thấy rõ bối cảnh hiện tại:

Các công ty dẫn đầu hiện tại:

Các LLM độc quyền như GPT-4, Gemini của Google và Claude dẫn đầu các điểm chuẩn. Trong các so sánh về "điểm ELO", các mô hình đóng luôn vượt trội hơn các mô hình mở, với các mô hình mở tập trung ở mức thấp hơn.

Lợi ích từ mô hình mở:

Khoảng cách đang dần thu hẹp. Các mô hình mở như Qwen-72B, Llama-2-70b-chat và Mistral-Medium hiện đang cạnh tranh với các hệ thống đóng. Các công ty công nghệ lớn thậm chí còn đang mở nguồn nhiều hơn cho dòng sản phẩm của mình với Gemma của Google và Phi-4 của Microsoft có các biến thể mở, và Llama 2 của Meta đã tìm thấy sức hút thương mại vào năm 2023.

Vượt ra ngoài Chatbot:

Các mô hình mở không chỉ bắt kịp trong văn bản; thay vào đó, họ đã dẫn đầu những đột phá trong các tác vụ hình ảnh (Stable Diffusion) và thị giác (CLIP), tăng cường sự tự tin vào các phương pháp tiếp cận mở.

Giải pháp lai:

Nhiều nhóm kết hợp các dịch vụ đóng (ví dụ: GPT-4) cho các khối lượng công việc cốt lõi với các mô hình mở nhỏ hơn để thử nghiệm, đạt được cả tính ổn định và tính linh hoạt.

Trong thực tế:

Đối với các tác vụ quan trọng (như tóm tắt nâng cao hoặc mã hóa), một mô hình đóng hàng đầu có thể là an toàn nhất hiện nay. Nếu bạn cần tùy chỉnh hoặc hiểu sâu về hành vi của mô hình, các mô hình mở hiện mang lại hiệu suất cạnh tranh với khả năng tinh chỉnh. Các khảo sát gần đây thậm chí còn cho thấy rằng "các mô hình nguồn mở nhỏ có thể theo kịp các mô hình nguồn đóng" trong nhiều tác vụ.

Niềm tin dựa trên sự giám sát pháp lý. Đạo luật AI của EU phân loại tất cả các mô hình nền tảng - mở hoặc đóng - theo mức độ rủi ro, đánh giá lợi ích kinh tế của nguồn mở đồng thời đảm bảo an toàn. Chính sách của Hoa Kỳ (Sắc lệnh Hành pháp AI năm 2023 của Biden) tập trung vào các phương pháp hay nhất của nhà cung cấp hơn là các nhãn mở. Tại Châu Âu, người dùng mô hình đóng phải chứng minh sự tuân thủ; người sửa đổi mô hình mở có thể phải chịu các nghĩa vụ quản trị dữ liệu.

Trên thực tế, điều này có nghĩa là các tổ chức phải tuân thủ các tiêu chuẩn minh bạch theo cả hai cách. Ví dụ: nếu bạn sử dụng mô hình đóng ở Châu Âu cho một ứng dụng có rủi ro cao, bạn phải chứng minh sự tuân thủ (ngay cả khi bạn không thể xem mã). Nếu bạn sửa đổi một mô hình mở, bạn có thể phải đối mặt với các nghĩa vụ pháp lý mới (như quản trị dữ liệu) như báo cáo của R Street đã cảnh báo.

Các phương pháp hay nhất

Hầu hết các chuyên gia ủng hộ phương pháp kết hợp: áp dụng các biện pháp kiểm soát truy cập hoặc cấp phép cho các mô hình nguồn mở mạnh mẽ ("lõi mở") và liên quan đến việc thiết lập chuẩn mực cộng đồng (ví dụ: hướng dẫn "phát hành có trách nhiệm"), trong khi các nhà cung cấp nguồn đóng công bố các tuyên bố về đạo đức và hợp tác về các tiêu chuẩn. Việc ra quyết định linh hoạt (quyền truy cập theo tầng cho các hệ thống mở và quy trình kiểm toán mở cho các hệ thống đóng) đảm bảo tính trách nhiệm.

Tìm hiểu cách bắt đầu Vibe Coding với AI (một cách dễ dàng).

Bảo mật: Lỗ hổng và Phòng thủ

Bảo mật củng cố niềm tin. Cả hệ thống AI mở và đóng đều phải đối mặt với các cuộc tấn công, nhưng phương pháp khác nhau:

Tấn công mô hình mở

Mã và trọng số công khai khiến các cuộc tấn công xâm phạm quyền riêng tư và đầu độc dễ dàng hơn. Các mối đe dọa như đảo ngược mô hình, suy luận thành viên, rò rỉ dữ liệu và cửa hậu là có thật, nhưng các bản vá do cộng đồng thúc đẩy và tinh chỉnh đồng nghĩa với việc các bản sửa lỗi có thể được triển khai nhanh chóng khi phát hiện ra lỗ hổng.

Tấn công mô hình đóng

Các nội dung ẩn bên trong yêu cầu bạn phải tin tưởng vào quá trình kiểm tra bảo mật của nhà cung cấp, nhưng lỗi vẫn có thể lọt qua. Ví dụ: một mô hình nền tảng nguồn mở đã từng bị lộ khóa API và nhật ký trò chuyện do lỗi. Để phòng thủ, nhiều nhà cung cấp triển khai tường lửa AI quét đầu vào và lọc đầu ra, đồng thời thực thi các lệnh gọi API đã xác thực bằng cách ghi nhật ký và giới hạn tốc độ.

Rủi ro nội bộ và chuỗi cung ứng

Các dự án nguồn mở phải bảo vệ chống lại các mã độc hại, trong khi các hệ thống đóng phải bảo mật đường ống dữ liệu và phần cứng của chúng. Các biện pháp phòng thủ phổ biến bao gồm kiểm toán mã chính thức, phần cứng được chứng nhận và môi trường tính toán đáng tin cậy.

Tìm kiếm sự cân bằng

Các chuyên gia khuyến nghị kết hợp tính minh bạch và kiểm soát: áp dụng thẻ mẫu và đánh giá bảo mật thường xuyên, công bố báo cáo minh bạch và thuê các "nhóm đỏ" của bên thứ ba để thăm dò cả mô hình mở và đóng. Cách tiếp cận này kết hợp sự giám sát của cộng đồng với các biện pháp bảo vệ cấp doanh nghiệp.

Quan điểm và Nền tảng của Nhà phát triển

Niềm tin của các nhà phát triển phụ thuộc vào cộng đồng và công cụ. Nhiều kỹ sư ưa chuộng mã nguồn mở để học hỏi và thử nghiệm trên các nền tảng như GitHub và Hugging Face. Các trang web tuyển dụng như Index.dev kiểm tra và tuyển chọn các nhà phát triển lành nghề, đảm bảo những người đóng góp đáng tin cậy cho bất kỳ dự án nào, dù mở hay đóng. Sự tin tưởng vào người viết mã AI cũng quan trọng như chính mã nguồn.

Sự tham gia của cộng đồng thúc đẩy niềm tin: các công ty phát hành mô hình mở hợp tác với các diễn đàn nhà phát triển để nhận phản hồi. Theo khảo sát StackOverflow đã đề cập trước đó, 57% nhà phát triển ưa chuộng các dự án mã nguồn mở trong khi chỉ 30% ủng hộ công nghệ độc quyền. Tư duy ủng hộ mở này dẫn đến việc báo cáo vấn đề, cải tiến và chia sẻ kiến thức nhiều hơn.

Các doanh nghiệp e ngại mô hình mở hơn các lỗ hổng quản trị giờ đây có thể lựa chọn các dự án mở cung cấp hỗ trợ hoặc chứng nhận cao cấp. Trong khi đó, các nhà cung cấp mô hình đóng cũng đang thu hút các nhà phát triển - ví dụ như Microsoft đã mở mã nguồn một số phần của dịch vụ nhận thức.

Điểm chính:

Niềm tin không chỉ nằm ở nhãn mở hay đóng. Nó phát triển thông qua lộ trình minh bạch, mô hình được chứng nhận và nhân tài được kiểm tra từ các mạng lưới đáng tin cậy.

Vậy, bạn nên quyết định mô hình nào đáng tin cậy? Hãy cân nhắc:

Mẹo thiết thực:

Ai nên quyết định?

Đội ngũ kỹ thuật và pháp lý của bạn, với sự đóng góp từ các chuyên viên đạo đức và có thể là các nhà lãnh đạo cộng đồng các nhà phát triển.

Cần làm gì?

Đánh giá các mô hình thông qua các điểm chuẩn (như trong các bài báo gần đây), thực hiện các bài kiểm tra bảo mật và kiểm tra giấy phép.

Sử dụng từng mô hình ở đâu/khi nào?

Sử dụng mô hình mở cho nghiên cứu, công cụ nội bộ và các sản phẩm do cộng đồng thúc đẩy; sử dụng mô hình đóng cho các hệ thống sản xuất quan trọng, nơi các đảm bảo là tối quan trọng.

Tại sao nên tin tưởng mô hình này hơn mô hình kia?

Điều này phụ thuộc vào khả năng chịu rủi ro và các giá trị của bạn: tính mở so với kiểm soát.

Làm thế nào để xây dựng niềm tin?

Kiểm tra kỹ lưỡng các nhà phát triển của bạn (xem các nền tảng như Index.dev), áp dụng các phương pháp hay nhất (kiểm toán thường xuyên, "nhóm đỏ", tài liệu) và cập nhật chính sách (ví dụ: tuân thủ Đạo luật AI của EU).

Kết luận: Cân bằng Niềm tin trong Thế giới AI

Việc lựa chọn giữa các mô hình AI mở và đóng không phải là chọn phe, mà là hiểu rõ nhu cầu của bạn.

Tính minh bạch, hiệu suất, bảo mật và cộng đồng đều là những yếu tố tạo nên niềm tin, và sự cân bằng phù hợp thường nằm ở việc kết hợp cả hai. Nguồn mở mang lại sự linh hoạt và khả năng cộng tác, trong khi nguồn đóng mang lại sự tinh tế và trách nhiệm giải trình.

Đối với nhiều tổ chức, chiến lược kết hợp là hợp lý nhất: tận dụng các mô hình mở để đổi mới và tinh chỉnh, đồng thời triển khai các mô hình đóng khi độ tin cậy là yếu tố then chốt. Điều quan trọng nhất là cách thức bạn triển khai, quản lý và bố trí nhân sự cho các nỗ lực AI của mình.

Các nền tảng như Index.dev đóng một vai trò quan trọng trong phương trình này, kết nối các doanh nghiệp với các nhà phát triển được kiểm tra kỹ lưỡng, những người mang đến cả chuyên môn và trách nhiệm giải trình. Bởi vì cuối cùng, AI đáng tin cậy không chỉ nằm ở mã nguồn. Nó nằm ở những con người đằng sau nó và các hoạt động thực hành xung quanh nó.

Niềm tin không phải là một nút bấm, nó là một hệ thống. Hãy xây dựng nó một cách có chủ đích.

Đối với các nhà phát triển:

Kết nối với các đội ngũ toàn cầu hàng đầu đang xây dựng các dự án AI có đạo đức. Làm việc từ xa, linh hoạt và bổ ích, chỉ có trên Index.dev.

Đối với khách hàng:

Cần các giải pháp AI đáng tin cậy? Thuê các nhà phát triển được kiểm tra từ Index.dev để xây dựng các hệ thống AI an toàn và đáng tin cậy cho doanh nghiệp của bạn.

Trust depends on your goals: closed models lead in performance and control, while open models win on transparency and flexibility. Discover which approach offers the best trust, security, and performance.

AI is transforming every industry, but trusting the right models is critical. The stakes are high: trust, governance, performance, ethics, and security all hang in the balance.

Closed-source models (e.g. GPT-4, Claude) lead today in raw performance and centralized safety controls.

Open-source models (e.g. Llama 2, Mistral) shine in transparency, customization, and community vetting.

Recent benchmarks show closed-source still outperforms on average, but open-source is narrowing the gap fast. Security experts warn open models risk easier attacks due to public weights, yet their transparency accelerates fixes, while closed models hide vulnerabilities but rely on vendor trust for patches.

Surveys of developers reinforce this debate: younger and early-career engineers especially value transparency. In fact, a 2025 StackOverflow survey found that “trust and learning are central to younger developers’ interactions with open-source AI”.

Major AI labs mirror this split: OpenAI keeps its flagship models behind API walled gardens for safety, while companies like Meta and Anthropic have open-sourced many models. Even policy makers are taking notice with the EU’s AI Act explicitly highlighting open-source as a public good.

In this article, we will dive deep into the open vs closed AI debate. We’ll explain what each approach means, who favors which, why trust matters, when and where each is appropriate, and how they compare on key fronts. Along the way we’ll examine performance benchmarks, security trade-offs, ethical considerations, and governance and policy implications.

By the end, you’ll have a clear, evidence-backed view on which models (and development practices) inspire confidence in which contexts.

Who’s Involved: Developers, Companies, and Communities

Who is shaping this debate? On one side are the open-source community and independent developers. The debate pits the open-source community (developers behind PyTorch, TensorFlow, Hugging Face, and countless GitHub projects) against AI companies that keep their latest models proprietary for control and IP protection.

Open advocates, 82% of whom have contributed to open-source tech, prize transparency, peer review, and shared innovation. Enterprises and regulators, meanwhile, lean on closed-source solutions (e.g., Azure OpenAI) to meet strict compliance in sectors like healthcare and finance. At conferences and on policy platforms, experts debate ‘open collaboration vs. closed control’ as a fundamental split in AI strategy.

Governments also weigh in: the EU’s 2023 AI Act highlights open‐source foundation models’ economic benefits while insisting on safety, and U.S. and Chinese policies similarly debate openness versus control. Yet these lines are blurring as OpenAI’s Sam Altman has noted the limits of full secrecy, and Meta’s Llama 2 release underscores industry-wide collaboration.

What Is Open-Source and Closed-Source AI?

What do we mean by “open-source AI” versus “closed-source AI”? In practice, open-source AI models are those whose code, model weights, and training data are published under permissive licenses (MIT, Apache, GPL, etc.) so that everybody can use and alter it. Consider projects such as LLaMA (Meta models) or Stable Diffusion.

They live on platforms like Hugging Face or GitHub, and a community of volunteers can inspect and improve them.

The key promise: full transparency. You can peer into architecture, training data (if published), and tweak the model.

By contrast, closed-source AI models are proprietary systems, often offered only via an API or commercial license. Companies keep the weights and code behind the scenes. You might use them through cloud services or products (e.g. ChatGPT, Bard, Azure Cognitive Services). The inner workings are not visible, and usage terms are fixed by the provider. The trade-off is control: providers say closed models let them enforce policies, fix bugs centrally, and monetize more easily.

Between these poles there are hybrid approaches:

Tiered models

Controlled releases

“Open core” with proprietary add-ons

Some systems (like Llama 2) are open with limited licenses; others are open-weight but require API keys. These hybrids attempt to balance openness with oversight.

The label also extends to tools: many libraries (PyTorch, Hugging Face Transformers, etc.) are open-source, enabling AI even for closed models. When we talk “open vs closed AI,” we're really asking who can see or change the model’s inner workings.

In essence, open-source AI = transparency and community, while closed-source AI = proprietary control.

Each side trusts different mechanisms to ensure reliable, ethical AI.

Explore 20 high-impact open-source GitHub projects to contribute to.

Pros and Cons of Each Approach

Why is this trust debate so heated? Because AI models can have profound impacts (some unintended) and handling that requires confidence in how they work.

Here are key factors:

Transparency vs. Secrecy

Open models let us audit code, inspect data sources, and test for biases, building confidence through visibility. That same openness exposes vulnerabilities (backdoors, data leaks) in plain sight. Closed models keep their internals hidden, so we must trust the provider’s safety and bias-mitigation claims.

Security

Open code invites security experts to find and fix flaws but this means that it also gives attackers the same blueprints. Closed models hide their architecture but rely on a few certified experts and internal audits. Providers like OpenAI add layers (for example, “AI firewalls” that vet prompts) to balance transparency with protection.

Performance

Proprietary LLMs (GPT-4, Claude) still top benchmarks, so we trust them for high-stakes tasks. But open models such as Mistral and Llama-2-70b are closing the gap fast, and in niche scenarios they can even outperform closed systems.

Ethics and Bias

With open models, we can review training data and apply ethical filters ourselves. That visibility also makes misuse (for disinformation or hate speech) easier. Closed models enforce rules centrally, but we must have faith in the vendor’s ethical priorities. Some propose “tiered openness” or public audits to get the best of both worlds.

Governance

Regulators face a challenge: if anyone can modify an open model, who’s accountable? Several recent papers (e.g. R Street Institute) argue regulators must adapt, since traditional product liability doesn’t fit easily. The EU AI Act acknowledges open-source benefits but requires safety guardrails, while U.S. policies focus on vendor responsibilities regardless of code status. Whether through community norms or corporate compliance, trustworthy governance is essential.

Community and Support

Open-source communities (forums, GitHub) offer rapid peer help and collective innovation as 57% of developers enjoy contributing to open projects. Closed ecosystems provide official SLAs and vendor support. Platforms like Index.dev bridge both by vetting talent, so we know skilled, trustworthy people are behind every AI system.

In short, open-source AI tends to earn trust through transparency, collaboration, and community oversight, at the cost of exposure to vulnerabilities and (until recently) lagging raw performance.

Closed-source AI earns trust through centralized control, security measures, and brand reputation, but it asks users to have faith in unseen processes. Both approaches have merits and pitfalls, and real-world solutions often mix elements of each.

Performance and Reliability: Head-to-Head

Let’s dig into performance which is a key aspect of trust for many users. If an AI chatbot reliably gives useful answers, users will trust it more. Recent benchmarks clearly show the landscape:

Current Leaders:

Proprietary LLMs like GPT-4, Google’s Gemini, and Claude top benchmarks. In “ELO score” comparisons, closed models consistently outshine open ones, with open models clustering at the lower end.

Open Gains:

The gap is closing. Open models such as Qwen-72B, Llama-2-70b-chat, and Mistral-Medium now rival closed systems. Big Tech is even open-sourcing more of its lineup with Google’s Gemma and Microsoft’s Phi-4 having open variants, and Meta’s Llama 2 found commercial traction in 2023.

Beyond Chatbots:

Open models aren’t just catching up in text; rather they’ve led breakthroughs in image (Stable Diffusion) and vision (CLIP) tasks, boosting confidence in open approaches.

Hybrid Solutions:

Many teams combine closed services (e.g., GPT-4) for core workloads with smaller open models for experimentation, achieving both stability and flexibility.

In Practice:

For mission-critical tasks (like advanced summarization or coding), a top-tier closed model may be safest today. If you need customization or a deep understanding of the model’s behavior, open models now deliver competitive performance with fine-tuning capabilities. Recent surveys even show that “small open-source models can keep up well with closed-source models” on many tasks.

Choosing the right tool means balancing immediate reliability and long-term adaptability. For learning and non-critical projects, open models shine with enterprises launching new AI features often start with closed offerings and layer in open frameworks for flexibility.

Ethics, Bias, and Governance

Ethics and Bias

Ethical AI demands responsible, fair behavior. Open models shine in transparency—anyone can audit and correct biases (e.g. Wikimedia’s “open-weight AI” policy and academic ethics frameworks)—but they’re also easier to tamper with. Closed models embed ethics through provider filters and alignment training.

Still, openness fuels safety research: the collaborative ecosystem drives new safeguards even as it spawns some malicious variants. Both must meet regulations like the EU AI Act, which mandates human oversight and “Human Autonomy.”

Governance and Policy

Trust rests on legal oversight. The EU AI Act treats all foundation models—open or closed—by risk tier, valuing open-source’s economic benefits while enforcing safety. U.S. policy (Biden’s 2023 AI Executive Order) focuses on vendor best practices over openness labels. In Europe, closed-model users must prove compliance; open-model modifiers may incur data-governance duties.

Practically, this means organizations must align with transparency standards either way. For example, if you use a closed model in Europe for a high-risk application, you have to demonstrate compliance (even if you can't see the code). If you modify an open model, you may face new legal duties (like data governance) as the R Street report warns.

Best Practices

Most experts advocate a hybrid approach: apply access controls or licensing to powerful open-source models (“open-core”) and involve community norm-setting (e.g. “responsible release” guidelines), while closed-source vendors publish ethics statements and collaborate on standards. Agile decision-making (tiered access for open systems and open audit pipelines for closed ones) ensures accountability.

Learn how to start Vibe Coding with AI(the easy way).

Security: Vulnerabilities and Defence

Security underpins trust. Open and closed AI systems both face attacks, but the methods differ:

Open-model attacks

Public code and weights make privacy and poisoning attacks easier. Threats like model inversion, membership inference, data leakage and backdoors are real, but community-driven patches and fine-tuning mean fixes can roll out quickly once flaws are spotted.

Closed-model attacks

Hidden internals require you to trust the provider’s security testing, yet bugs still slip through. For example, an open-source foundation model once exposed API keys and chat logs due to a flaw. To defend, many vendors deploy AI firewalls that scan inputs and filter outputs, and they enforce authenticated API calls with logging and rate limits.

Insider and supply-chain risks

Open-source projects must guard against malicious code contributions, while closed systems must secure their data pipelines and hardware. Common defenses include formal code audits, certified hardware and trusted compute environments.

Finding the balance

Experts recommend combining transparency and control: adopt model cards and regular security reviews, publish transparency reports, and engage third-party“red teams” to probe both open and closed models. This approach merges community scrutiny with enterprise-grade safeguards.

Developer Perspective and Platforms

Trust for developers hinges on community and tooling. Many engineers favour open source to learn and experiment on platforms like GitHub and Hugging Face. Talent sites such as Index.dev vet and curate skilled developers, ensuring trusted contributors to any project, open or closed. Confidence in who writes the AI code is nearly as vital as the code itself.

Community engagement boosts trust: firms releasing open models partner with developer forums for feedback. According to the previously mentioned StackOverflow survey, 57% of developers prefer open-source projects while only 30% favour proprietary technology. This pro-open mindset leads to more issue reporting, enhancements and knowledge sharing.

Enterprises wary of open models over governance gaps can now opt for open projects that provide premium support or certification. Meanwhile, closed-model providers are courting developers too—Microsoft, for instance, has open-sourced parts of its cognitive services.

Key takeaway:

Trust does not lie solely in open or closed labels. It grows through transparent roadmaps, certified models and vetted talent from reliable networks.

So, how should you decide which model to trust? Consider:

Practical Tips:

Who should decide?

Your engineering and legal teams, with input from ethics officers and maybe developer community leaders.

What to do?

Evaluate models via benchmarks (like those in recent papers), perform security tests, and check licenses.

Where/When to use each?

Use open for research, internal tools, and community-driven products; use closed for critical production systems where guarantees are paramount.

Why trust one over the other?

It boils down to your risk tolerance and values: openness vs control.

How to build trust?

Vet your developers (see platforms like Index.dev), adopt best practices (regular audits, “red teams”, documentation), and stay updated on policy (e.g. EU AI Act compliance).

Conclusion: Balancing Trust in an AI World

Choosing between open and closed AI models isn’t about picking sides, it’s about understanding your needs.

Transparency, performance, security, and community all factor into trust, and the right balance often lies in combining both worlds. Open-source offers you flexibility and collaboration while closed-source provides polish and accountability.

For many organizations, a hybrid strategy makes the most sense: leverage open models for innovation and fine-tuning, and deploy closed models where reliability is critical. What matters most is how you implement, govern, and staff your AI efforts.

Platforms like Index.dev play a valuable role in this equation, connecting businesses with thoroughly vetted developers who bring both expertise and accountability to the table. Because in the end, trustworthy AI isn’t just about the code. It’s about the people behind it, and the practices around it.

Trust isn’t a toggle, it’s a system. Build it deliberately.

For Developers:

Get matched with top global teams building ethical AI projects. Remote, flexible, and rewarding, only on Index.dev.

For Clients:

Need trusted AI solutions? Hire vetted developers from Index.dev to build secure and reliable AI systems for your business.

Dịch: Lê Trung Nghĩa

letrungnghia.foss@gmail.com

Tác giả: Nghĩa Lê Trung

Ý kiến bạn đọc

Những tin mới hơn

Những tin cũ hơn

Blog này được chuyển đổi từ http://blog.yahoo.com/letrungnghia trên Yahoo Blog sang sử dụng NukeViet sau khi Yahoo Blog đóng cửa tại Việt Nam ngày 17/01/2013.Kể từ ngày 07/02/2013, thông tin trên Blog được cập nhật tiếp tục trở lại với sự hỗ trợ kỹ thuật và đặt chỗ hosting của nhóm phát triển...

DigComp 3.0: Khung năng lực số châu Âu

DigComp 3.0: Khung năng lực số châu Âu

Các bài toàn văn trong năm 2025

Các bài toàn văn trong năm 2025

Các bài trình chiếu trong năm 2025

Các bài trình chiếu trong năm 2025

Các lớp tập huấn thực hành ‘Khai thác tài nguyên giáo dục mở’ tới hết năm 2025

Các lớp tập huấn thực hành ‘Khai thác tài nguyên giáo dục mở’ tới hết năm 2025

Tập huấn thực hành ‘Khai thác tài nguyên giáo dục mở’ cho giáo viên phổ thông, bao gồm cả giáo viên tiểu học và mầm non tới hết năm 2025

Tập huấn thực hành ‘Khai thác tài nguyên giáo dục mở’ cho giáo viên phổ thông, bao gồm cả giáo viên tiểu học và mầm non tới hết năm 2025

Các tài liệu dịch sang tiếng Việt tới hết năm 2025

Các tài liệu dịch sang tiếng Việt tới hết năm 2025

Loạt bài về AI và AI Nguồn Mở: Công cụ AI; Dự án AI Nguồn Mở; LLM Nguồn Mở; Kỹ thuật lời nhắc;

Loạt bài về AI và AI Nguồn Mở: Công cụ AI; Dự án AI Nguồn Mở; LLM Nguồn Mở; Kỹ thuật lời nhắc;

Tổng hợp các bài của Nhóm các Nhà cấp vốn Nghiên cứu Mở (ORFG) đã được dịch sang tiếng Việt

Tổng hợp các bài của Nhóm các Nhà cấp vốn Nghiên cứu Mở (ORFG) đã được dịch sang tiếng Việt

Tổng hợp các bài của Liên minh S (cOAlition S) đã được dịch sang tiếng Việt

Tổng hợp các bài của Liên minh S (cOAlition S) đã được dịch sang tiếng Việt

Năm Khoa học Mở & Chuyển đổi sang Khoa học Mở - Tổng hợp các bài liên quan

Năm Khoa học Mở & Chuyển đổi sang Khoa học Mở - Tổng hợp các bài liên quan

Bạn cần biết những gì về các khung năng lực AI mới của UNESCO cho học sinh và giáo viên

Bạn cần biết những gì về các khung năng lực AI mới của UNESCO cho học sinh và giáo viên

Bàn về 'Lợi thế của doanh nghiệp Việt là dữ liệu Việt, bài toán Việt' - bài phát biểu của Bộ trưởng Nguyễn Mạnh Hùng ngày 21/08/2025

Bàn về 'Lợi thế của doanh nghiệp Việt là dữ liệu Việt, bài toán Việt' - bài phát biểu của Bộ trưởng Nguyễn Mạnh Hùng ngày 21/08/2025

Khung năng lực AI cho giáo viên

Khung năng lực AI cho giáo viên

‘Khung năng lực AI cho giáo viên’ - bản dịch sang tiếng Việt

‘Khung năng lực AI cho giáo viên’ - bản dịch sang tiếng Việt

‘KHUYẾN NGHỊ VÀ HƯỚNG DẪN TRUY CẬP MỞ KIM CƯƠNG cho các cơ sở, nhà cấp vốn, nhà bảo trợ, nhà tài trợ, và nhà hoạch định chính sách’ - bản dịch sang tiếng Việt

‘KHUYẾN NGHỊ VÀ HƯỚNG DẪN TRUY CẬP MỞ KIM CƯƠNG cho các cơ sở, nhà cấp vốn, nhà bảo trợ, nhà tài trợ, và nhà hoạch định chính sách’ - bản dịch sang tiếng Việt

Mark Zuckerberg: DeepSeek cho thấy vì sao nước Mỹ phải là ‘tiêu chuẩn nguồn mở toàn cầu’ của AI; không có lý do gì để suy nghĩ lại về việc chi tiêu

Mark Zuckerberg: DeepSeek cho thấy vì sao nước Mỹ phải là ‘tiêu chuẩn nguồn mở toàn cầu’ của AI; không có lý do gì để suy nghĩ lại về việc chi tiêu

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm)

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm)

DeepSeek đã gây ra sự hoảng loạn trên thị trường — nhưng một số người cho rằng việc bán tháo là quá mức

DeepSeek đã gây ra sự hoảng loạn trên thị trường — nhưng một số người cho rằng việc bán tháo là quá mức

Nhà khoa học AI hàng đầu của Meta cho biết thành công của DeepSeek cho thấy 'các mô hình nguồn mở đang vượt trội hơn các mô hình độc quyền'

Nhà khoa học AI hàng đầu của Meta cho biết thành công của DeepSeek cho thấy 'các mô hình nguồn mở đang vượt trội hơn các mô hình độc quyền'

“Chúng tôi không có hào nước”: Sự đổi mới đột phá của AI nguồn mở

“Chúng tôi không có hào nước”: Sự đổi mới đột phá của AI nguồn mở

‘Đặc tả Khung Tính mở Mô hình (MOF)’ của LF AI & Data - Tài sản chung của AI Tạo sinh - bản dịch sang tiếng Việt

‘Đặc tả Khung Tính mở Mô hình (MOF)’ của LF AI & Data - Tài sản chung của AI Tạo sinh - bản dịch sang tiếng Việt

‘LỘ TRÌNH CỦA TỔNG THƯ KÝ LIÊN HIỆP QUỐC VỀ HỢP TÁC KỸ THUẬT SỐ THÚC ĐẨY HÀNG HÓA CÔNG CỘNG KỸ THUẬT SỐ’ - bản dịch sang tiếng Việt

‘LỘ TRÌNH CỦA TỔNG THƯ KÝ LIÊN HIỆP QUỐC VỀ HỢP TÁC KỸ THUẬT SỐ THÚC ĐẨY HÀNG HÓA CÔNG CỘNG KỸ THUẬT SỐ’ - bản dịch sang tiếng Việt

AI trong TVET - Một vài gợi ý triển khai trong thực tế

AI trong TVET - Một vài gợi ý triển khai trong thực tế

Dữ liệu để phân loại AI

Dữ liệu để phân loại AI

Tài sản chung kỹ thuật số và Hàng hóa Công cộng Kỹ thuật số - Tìm thấy nền tảng chung cho các nhà hoạch định chính sách

Tài sản chung kỹ thuật số và Hàng hóa Công cộng Kỹ thuật số - Tìm thấy nền tảng chung cho các nhà hoạch định chính sách

Khung năng lực AI cho học sinh

Khung năng lực AI cho học sinh

Nếu DeepSeek muốn trở thành một người phá vỡ thực sự, nó phải tiến xa hơn nữa về tính minh bạch của dữ liệu

Nếu DeepSeek muốn trở thành một người phá vỡ thực sự, nó phải tiến xa hơn nữa về tính minh bạch của dữ liệu

Mark Zuckerberg nói Meta có kế hoạch chi hơn 60 tỷ USD khi Thung lũng silicon hoảng loạn về sự cạnh tranh của AI Trung Quốc

Mark Zuckerberg nói Meta có kế hoạch chi hơn 60 tỷ USD khi Thung lũng silicon hoảng loạn về sự cạnh tranh của AI Trung Quốc

‘Xây dựng cách tiếp cận minh bạch dữ liệu AI lấy người dùng làm trung tâm’ - bản dịch sang tiếng Việt

‘Xây dựng cách tiếp cận minh bạch dữ liệu AI lấy người dùng làm trung tâm’ - bản dịch sang tiếng Việt

Tọa đàm ‘Vai trò của Tài nguyên Giáo dục Mở trong chuyển đổi số giáo dục đại học’ tại Viện Chuyển đổi số và Học liệu - Đại học Huế, ngày 12/09/2025

Tọa đàm ‘Vai trò của Tài nguyên Giáo dục Mở trong chuyển đổi số giáo dục đại học’ tại Viện Chuyển đổi số và Học liệu - Đại học Huế, ngày 12/09/2025