Top 12 Open Source AI Projects to Add to Your Tech Stack. 11. Hugging Face Transformers

Theo: https://www.digitalocean.com/resources/articles/open-source-ai-platforms

Bài được đưa lên Internet ngày: 10/02/2024

Sự quan tâm đến AI nguồn mở ngày càng tăng, và có rất nhiều mô hình có sẵn mà bạn có thể sử dụng để xây dựng các chương trình và ứng dụng cho nhiều trường hợp sử dụng khác nhau. 12 công cụ và nền tảng AI nguồn mở này có thể được sử dụng cho máy học, chatbot, AI tăng tốc GPU, học sâu và phân tích dữ liệu.

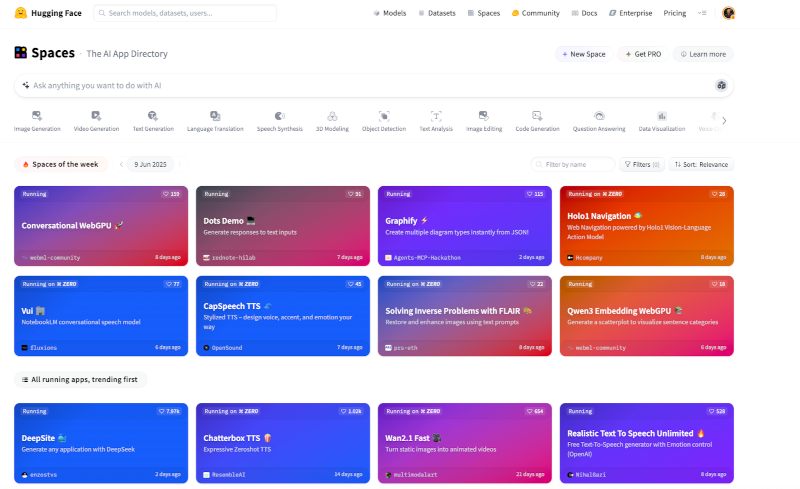

Hugging Face Transformers là các mô hình mã nguồn mở, được đào tạo sẵn cho suy luận và huấn luyện. Bạn có thể sử dụng chúng để huấn luyện mô hình, xây dựng ứng dụng và tạo văn bản cho các mô hình ngôn ngữ lớn. Chúng cung cấp API và hỗ trợ cho các framework PyTorch, TensorFlow và JAX, đồng thời hợp lý hóa quy trình xây dựng mô hình bằng cách cung cấp tất cả các thành phần cần thiết cho việc huấn luyện hoặc suy luận mô hình. Điều này bao gồm một quy trình hỗ trợ các tác vụ học máy, một trình huấn luyện toàn diện và các hàm hỗ trợ tạo văn bản. Hiện có hơn 63.000 bộ biến đổi có sẵn cho nhiều ứng dụng AI và máy học khác nhau.

Trọng tâm: Các mô hình được đào tạo sẵn cho việc phát triển ứng dụng suy luận hoặc học máy.

Điểm mạnh:

Tài liệu toàn diện và một cộng đồng hoạt động thường xuyên có thể cung cấp hỗ trợ, các bộ biến đổi mới và tài liệu.

Các bộ biến đổi có sẵn cho nhiều tác vụ học máy khác nhau, chẳng hạn như trích xuất câu trả lời, phát hiện đối tượng, tạo tóm tắt, phiên âm âm thanh và phân đoạn hình ảnh.

Giao diện thân thiện với người dùng và tích hợp dễ dàng với các công cụ khoa học dữ liệu.

Một cộng đồng thường xuyên phát triển, tạo ra các cải tiến và tích hợp các bản cập nhật.

Điểm yếu:

Một số bộ chuyển đổi và mô hình có thể yêu cầu tài nguyên tính toán lớn.

Hub bao gồm một loạt các mô hình, một số có thể đã lỗi thời hoặc không được cập nhật thường xuyên.

Về mục lục ………. Phần trước ………. Phần tiếp theo

Hugging Face Transformers are open source, pre-trained models for inference and training. You can use them to train models, build applications, and generate text for large language models. They offer APIs and support for PyTorch, TensorFlow, and JAX frameworks and streamline the model-building process by providing all the necessary components for model training or inference. This includes a pipeline to support machine learning tasks, a comprehensive trainer, and functions to help with text generation. There are currently over 63,000 transformers available for a wide variety of AI and machine learning applications.

Focus: Pre-trained models for inference or machine learning application development

Strengths:

Comprehensive documentation and a regularly active community that can provide assistance, new transformers, and documentation.

Transformers are available for a wide variety of machine learning tasks, such as answer extraction, object detection, summary creation, audio transcription, and image segmentation.

User-friendly interface and easy integration with data science tools.

A community that regularly evolves and produces innovations and integrates updates.

Weaknesses:

Certain transformers and models may require extensive computing resources.

Hub includes an extensive array of models, some of which might be out of date or might not receive regular updates.

Dịch: Lê Trung Nghĩa

letrungnghia.foss@gmail.com

Tác giả: Nghĩa Lê Trung

Ý kiến bạn đọc

Những tin mới hơn

Những tin cũ hơn

Blog này được chuyển đổi từ http://blog.yahoo.com/letrungnghia trên Yahoo Blog sang sử dụng NukeViet sau khi Yahoo Blog đóng cửa tại Việt Nam ngày 17/01/2013.Kể từ ngày 07/02/2013, thông tin trên Blog được cập nhật tiếp tục trở lại với sự hỗ trợ kỹ thuật và đặt chỗ hosting của nhóm phát triển...

DigComp 3.0: Khung năng lực số châu Âu

DigComp 3.0: Khung năng lực số châu Âu

Các bài toàn văn trong năm 2025

Các bài toàn văn trong năm 2025

Các bài trình chiếu trong năm 2025

Các bài trình chiếu trong năm 2025

Các lớp tập huấn thực hành ‘Khai thác tài nguyên giáo dục mở’ tới hết năm 2025

Các lớp tập huấn thực hành ‘Khai thác tài nguyên giáo dục mở’ tới hết năm 2025

Tập huấn thực hành ‘Khai thác tài nguyên giáo dục mở’ cho giáo viên phổ thông, bao gồm cả giáo viên tiểu học và mầm non tới hết năm 2025

Tập huấn thực hành ‘Khai thác tài nguyên giáo dục mở’ cho giáo viên phổ thông, bao gồm cả giáo viên tiểu học và mầm non tới hết năm 2025

Các tài liệu dịch sang tiếng Việt tới hết năm 2025

Các tài liệu dịch sang tiếng Việt tới hết năm 2025

Loạt bài về AI và AI Nguồn Mở: Công cụ AI; Dự án AI Nguồn Mở; LLM Nguồn Mở; Kỹ thuật lời nhắc;

Loạt bài về AI và AI Nguồn Mở: Công cụ AI; Dự án AI Nguồn Mở; LLM Nguồn Mở; Kỹ thuật lời nhắc;

Tổng hợp các bài của Nhóm các Nhà cấp vốn Nghiên cứu Mở (ORFG) đã được dịch sang tiếng Việt

Tổng hợp các bài của Nhóm các Nhà cấp vốn Nghiên cứu Mở (ORFG) đã được dịch sang tiếng Việt

Tổng hợp các bài của Liên minh S (cOAlition S) đã được dịch sang tiếng Việt

Tổng hợp các bài của Liên minh S (cOAlition S) đã được dịch sang tiếng Việt

Năm Khoa học Mở & Chuyển đổi sang Khoa học Mở - Tổng hợp các bài liên quan

Năm Khoa học Mở & Chuyển đổi sang Khoa học Mở - Tổng hợp các bài liên quan

Bàn về 'Lợi thế của doanh nghiệp Việt là dữ liệu Việt, bài toán Việt' - bài phát biểu của Bộ trưởng Nguyễn Mạnh Hùng ngày 21/08/2025

Bàn về 'Lợi thế của doanh nghiệp Việt là dữ liệu Việt, bài toán Việt' - bài phát biểu của Bộ trưởng Nguyễn Mạnh Hùng ngày 21/08/2025

‘KHUYẾN NGHỊ VÀ HƯỚNG DẪN TRUY CẬP MỞ KIM CƯƠNG cho các cơ sở, nhà cấp vốn, nhà bảo trợ, nhà tài trợ, và nhà hoạch định chính sách’ - bản dịch sang tiếng Việt

‘KHUYẾN NGHỊ VÀ HƯỚNG DẪN TRUY CẬP MỞ KIM CƯƠNG cho các cơ sở, nhà cấp vốn, nhà bảo trợ, nhà tài trợ, và nhà hoạch định chính sách’ - bản dịch sang tiếng Việt

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm)

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm)

‘Đặc tả Khung Tính mở Mô hình (MOF)’ của LF AI & Data - Tài sản chung của AI Tạo sinh - bản dịch sang tiếng Việt

‘Đặc tả Khung Tính mở Mô hình (MOF)’ của LF AI & Data - Tài sản chung của AI Tạo sinh - bản dịch sang tiếng Việt

‘LỘ TRÌNH CỦA TỔNG THƯ KÝ LIÊN HIỆP QUỐC VỀ HỢP TÁC KỸ THUẬT SỐ THÚC ĐẨY HÀNG HÓA CÔNG CỘNG KỸ THUẬT SỐ’ - bản dịch sang tiếng Việt

‘LỘ TRÌNH CỦA TỔNG THƯ KÝ LIÊN HIỆP QUỐC VỀ HỢP TÁC KỸ THUẬT SỐ THÚC ĐẨY HÀNG HÓA CÔNG CỘNG KỸ THUẬT SỐ’ - bản dịch sang tiếng Việt

AI trong TVET - Một vài gợi ý triển khai trong thực tế

AI trong TVET - Một vài gợi ý triển khai trong thực tế

Tọa đàm ‘Vai trò của Tài nguyên Giáo dục Mở trong chuyển đổi số giáo dục đại học’ tại Viện Chuyển đổi số và Học liệu - Đại học Huế, ngày 12/09/2025

Tọa đàm ‘Vai trò của Tài nguyên Giáo dục Mở trong chuyển đổi số giáo dục đại học’ tại Viện Chuyển đổi số và Học liệu - Đại học Huế, ngày 12/09/2025

‘Hiệp ước Kỹ thuật số Toàn cầu’ của Liên hiệp quốc - bản dịch sang tiếng Việt

‘Hiệp ước Kỹ thuật số Toàn cầu’ của Liên hiệp quốc - bản dịch sang tiếng Việt

12 dự án AI Nguồn Mở hàng đầu để bổ sung vào kho công nghệ của bạn. 11. Hugging Face Transformers

12 dự án AI Nguồn Mở hàng đầu để bổ sung vào kho công nghệ của bạn. 11. Hugging Face Transformers

Dự án DIAMAS đưa ra Khuyến nghị và Hướng dẫn Truy cập Mở Kim cương

Dự án DIAMAS đưa ra Khuyến nghị và Hướng dẫn Truy cập Mở Kim cương

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm) - Trợ lý AI tốt nhất (chatbots)

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm) - Trợ lý AI tốt nhất (chatbots)

Hướng dẫn kỹ thuật lời nhắc. Kỹ thuật viết lời nhắc. Lời nhắc Tái Hành động (ReAct)

Hướng dẫn kỹ thuật lời nhắc. Kỹ thuật viết lời nhắc. Lời nhắc Tái Hành động (ReAct)

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm) - Trình tạo nhạc AI tốt nhất

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm) - Trình tạo nhạc AI tốt nhất

Nâng cao tính mở và khả năng sử dụng của Hàng hóa Công cộng Kỹ thuật số bằng cách chỉ chấp nhận các bộ sưu tập nội dung và bộ dữ liệu hoàn toàn được cấp phép mở

Nâng cao tính mở và khả năng sử dụng của Hàng hóa Công cộng Kỹ thuật số bằng cách chỉ chấp nhận các bộ sưu tập nội dung và bộ dữ liệu hoàn toàn được cấp phép mở

Vì sao Singapore đang xây dựng hàng hóa công cộng kỹ thuật số

Vì sao Singapore đang xây dựng hàng hóa công cộng kỹ thuật số

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm) - Công cụ AI quản lý kiến thức tốt nhất

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm) - Công cụ AI quản lý kiến thức tốt nhất

Hiểu các giấy phép CC và đào tạo AI: Một tóm tắt về pháp lý

Hiểu các giấy phép CC và đào tạo AI: Một tóm tắt về pháp lý

Chiến lược 2023-2028 của DPGA

Chiến lược 2023-2028 của DPGA

Hướng dẫn nghiên cứu của khoa về ChatGPT và các công cụ AI

Hướng dẫn nghiên cứu của khoa về ChatGPT và các công cụ AI

Các công cụ pháp lý CC được thừa nhận là Hàng hóa Công cộng Kỹ thuật số

Các công cụ pháp lý CC được thừa nhận là Hàng hóa Công cộng Kỹ thuật số