Hướng dẫn kỹ thuật lời nhắc. Kỹ thuật viết lời nhắc. Lời nhắc theo chuỗi tư duy

Thứ bảy - 01/11/2025 06:21

Chain-of-Thought Prompting

Theo: https://www.promptingguide.ai/techniques/cot

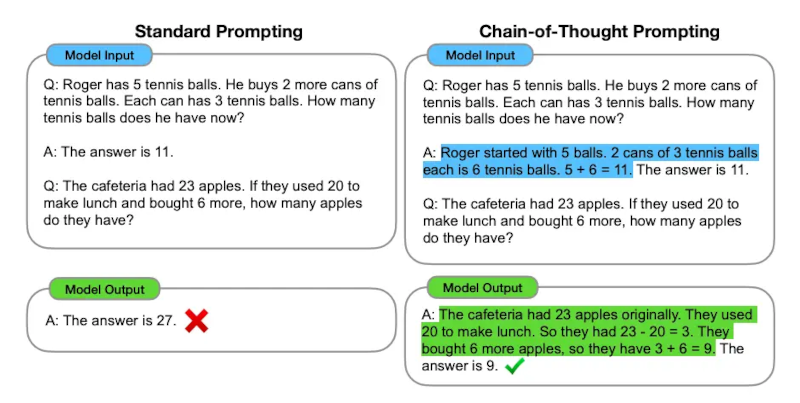

Image Source: Wei et al. (2022)

Được giới thiệu trong Wei et al. (2022), lời nhắc theo chuỗi tư duy - CoT (Chain-of-Thought) cho phép khả năng suy luận phức tạp thông qua các bước suy luận trung gian. Bạn có thể kết hợp nó với lời nhắc với vài ví dụ/minh họa (Few-shot Prompting) để đạt kết quả tốt hơn cho các nhiệm vụ phức tạp hơn đòi hỏi phải suy luận trước khi phản hồi.

Prompt:

Các số lẻ trong nhóm này cộng lại thành một số chẵn: 4, 8, 9, 15, 12, 2, 1.Đáp án: Cộng tất cả các số lẻ (9, 15, 1) được 25. Đáp án là Sai.Các số lẻ trong nhóm này cộng lại thành một số chẵn: 17, 10, 19, 4, 8, 12, 24.Đáp án: Cộng tất cả các số lẻ (17, 19) được 36. Đáp án là Đúng.Các số lẻ trong nhóm này cộng lại thành một số chẵn: 16, 11, 14, 4, 8, 13, 24.Đáp án: Cộng tất cả các số lẻ (11, 13) được 24. Đáp án là Đúng.Các số lẻ trong nhóm này cộng lại thành một số chẵn: 17, 9, 10, 12, 13, 4, 2.Đáp án: Cộng tất cả các số lẻ (17, 9, 13) được 39. Đáp án sai.Các số lẻ trong nhóm này cộng lại thành một số chẵn: 15, 32, 5, 13, 82, 7, 1.Đáp án:

Output:

Cộng tất cả các số lẻ (15, 5, 13, 7, 1) được 41. Đáp án là Sai.

Wow! Chúng ta có thể thấy một kết quả hoàn hảo khi đưa ra bước lập luận. Thực tế, chúng ta có thể giải quyết bài toán này bằng cách cung cấp ít ví dụ hơn nữa, tức là chỉ cần một ví dụ là đủ:

Prompt:

Các số lẻ trong nhóm này cộng lại thành một số chẵn: 4, 8, 9, 15, 12, 2, 1.Đáp án: Cộng tất cả các số lẻ (9, 15, 1) được 25. Đáp án là Sai.Các số lẻ trong nhóm này cộng lại thành một số chẵn: 15, 32, 5, 13, 82, 7, 1.Đáp án:

Output:

Cộng tất cả các số lẻ (15, 5, 13, 7, 1) được 41. Đáp án là Sai.

Lưu ý rằng các tác giả cho rằng đây là một khả năng mới nổi xuất hiện với các mô hình ngôn ngữ đủ lớn.

Lời nhắc không có ví dụ/minh họa (COT Zero-shot)

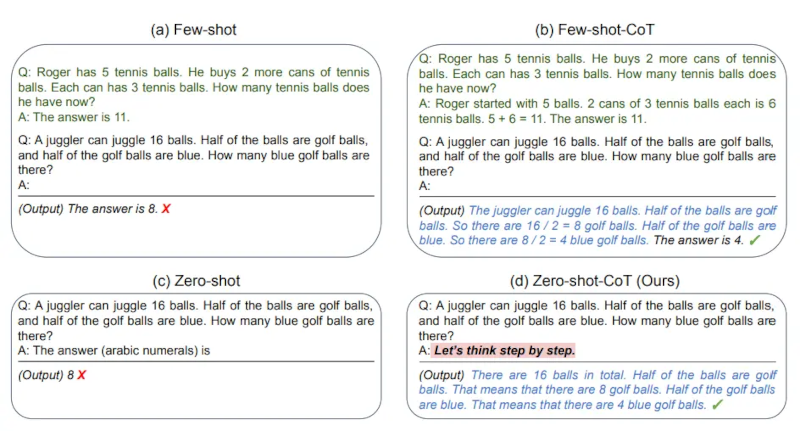

Image Source: Kojima et al. (2022)

Một ý tưởng mới xuất hiện gần đây hơn là ý tưởng về chiến lược Zero-shot CoT (Kojima và cộng sự, 2022), về cơ bản bao gồm việc thêm câu "Hãy suy nghĩ từng bước" vào lời nhắc ban đầu. Hãy thử một bài toán đơn giản và xem mô hình hoạt động như thế nào:

Prompt:

Tôi ra chợ mua 10 quả táo. Tôi đưa 2 quả cho người hàng xóm và 2 quả cho thợ sửa chữa. Sau đó, tôi đi mua thêm 5 quả táo và ăn 1 quả. Hỏi tôi còn lại bao nhiêu quả táo?

Output:

11 quả táo

Câu trả lời không đúng! Bây giờ chúng ta hãy thử với lời nhắc đặc biệt.

Prompt:

Tôi ra chợ mua 10 quả táo. Tôi đưa 2 quả cho người hàng xóm và 2 quả cho thợ sửa chữa. Sau đó, tôi mua thêm 5 quả táo và ăn 1 quả. Vậy tôi còn lại bao nhiêu quả táo?Hãy suy nghĩ theo từng bước một.

Output:

Ban đầu, bạn có 10 quả táo.Bạn đã tặng 2 quả táo cho người hàng xóm và 2 quả cho thợ sửa chữa, vậy bạn còn lại 6 quả táo.Sau đó, bạn mua thêm 5 quả táo, vậy là bạn còn lại 11 quả táo.Cuối cùng, bạn ăn 1 quả táo, vậy là bạn còn lại 10 quả táo.

Thật ấn tượng khi lời nhắc đơn giản này lại hiệu quả trong nhiệm vụ này. Điều này đặc biệt hữu ích khi bạn không có quá nhiều ví dụ để sử dụng trong lời nhắc.

Chuỗi tư duy Tự động (Auto-CoT)

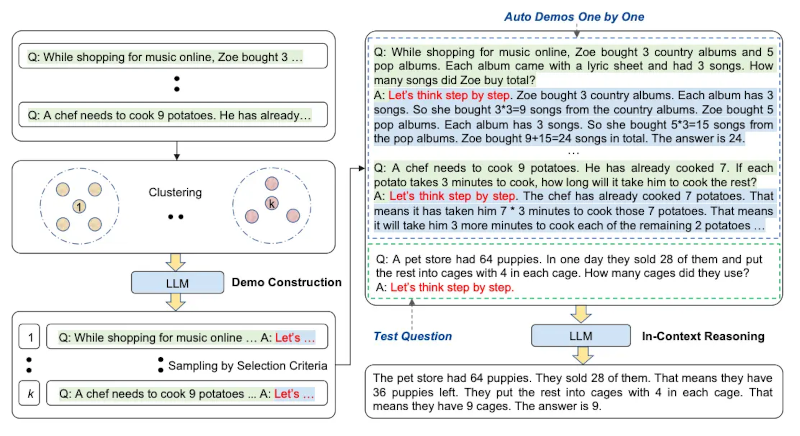

Khi áp dụng lời nhắc theo chuỗi tư duy với các bài minh họa, quá trình này bao gồm việc tự tay tạo ra các ví dụ hiệu quả và đa dạng. Nỗ lực thủ công này có thể dẫn đến các giải pháp không tối ưu. Zhang và cộng sự (2022) đề xuất một phương pháp để loại bỏ các nỗ lực thủ công bằng cách tận dụng các chương trình học thuật (LLM) với lời nhắc "Hãy suy nghĩ từng bước" để tạo ra các chuỗi suy luận cho từng bài minh họa. Quá trình tự động này vẫn có thể dẫn đến sai sót trong các chuỗi được tạo ra. Để giảm thiểu ảnh hưởng của sai sót, tính đa dạng của các bài minh họa là rất quan trọng. Nghiên cứu này đề xuất Auto-CoT, phương pháp này lấy mẫu các câu hỏi với tính đa dạng và tạo ra các chuỗi suy luận để xây dựng các bài minh họa.

Chuỗi tư duy tự động (Auto-CoT) bao gồm hai giai đoạn chính:

-

Giai đoạn 1): Phân cụm câu hỏi: Phân chia các câu hỏi của một tập dữ liệu nhất định thành một vài cụm

-

Giai đoạn 2): Lấy mẫu trình diễn: Chọn một câu hỏi đại diện từ mỗi cụm và tạo chuỗi suy luận của nó bằng Zero-Shot-CoT (Chuỗi tư duy không có ví dụ/minh họa) với các phương pháp suy luận đơn giản

Các phương pháp suy luận đơn giản có thể là độ dài của câu hỏi (ví dụ: 60 mã thông báo) và số bước trong quá trình suy luận (ví dụ: 5 bước suy luận). Điều này khuyến khích mô hình sử dụng các minh họa đơn giản và chính xác.

Quá trình này được minh họa dưới đây:

Image Source: Zhang et al. (2022)

Mã cho chuỗi tư duy tự động (Auto-CoT) có sẵn ở đây.

Về ‘Kỹ thuật viết lời nhắc’ ………. Phần trước ………. Phần tiếp theo

Introduced in Wei et al. (2022), chain-of-thought (CoT) prompting enables complex reasoning capabilities through intermediate reasoning steps. You can combine it with few-shot prompting to get better results on more complex tasks that require reasoning before responding.

Prompt:

The odd numbers in this group add up to an even number: 4, 8, 9, 15, 12, 2, 1.A: Adding all the odd numbers (9, 15, 1) gives 25. The answer is False.The odd numbers in this group add up to an even number: 17, 10, 19, 4, 8, 12, 24.A: Adding all the odd numbers (17, 19) gives 36. The answer is True.The odd numbers in this group add up to an even number: 16, 11, 14, 4, 8, 13, 24.A: Adding all the odd numbers (11, 13) gives 24. The answer is True.The odd numbers in this group add up to an even number: 17, 9, 10, 12, 13, 4, 2.A: Adding all the odd numbers (17, 9, 13) gives 39. The answer is False.The odd numbers in this group add up to an even number: 15, 32, 5, 13, 82, 7, 1.A:

Output:

Adding all the odd numbers (15, 5, 13, 7, 1) gives 41. The answer is False.

Wow! We can see a perfect result when we provided the reasoning step. In fact, we can solve this task by providing even fewer examples, i.e., just one example seems enough:

Prompt:

The odd numbers in this group add up to an even number: 4, 8, 9, 15, 12, 2, 1.A: Adding all the odd numbers (9, 15, 1) gives 25. The answer is False.The odd numbers in this group add up to an even number: 15, 32, 5, 13, 82, 7, 1.A:

Output:

Adding all the odd numbers (15, 5, 13, 7, 1) gives 41. The answer is False.

Keep in mind that the authors claim that this is an emergent ability that arises with sufficiently large language models.

Zero-shot COT Prompting

One recent idea that came out more recently is the idea of zero-shot CoT (Kojima et al. 2022) that essentially involves adding "Let's think step by step" to the original prompt. Let's try a simple problem and see how the model performs:

Prompt:

I went to the market and bought 10 apples. I gave 2 apples to the neighbor and 2 to the repairman. I then went and bought 5 more apples and ate 1. How many apples did I remain with?

Output:

11 apples

The answer is incorrect! Now Let's try with the special prompt.

Prompt:

I went to the market and bought 10 apples. I gave 2 apples to the neighbor and 2 to the repairman. I then went and bought 5 more apples and ate 1. How many apples did I remain with?Let's think step by step.

Output:

First, you started with 10 apples.You gave away 2 apples to the neighbor and 2 to the repairman, so you had 6 apples left.Then you bought 5 more apples, so now you had 11 apples.Finally, you ate 1 apple, so you would remain with 10 apples.

It's impressive that this simple prompt is effective at this task. This is particularly useful where you don't have too many examples to use in the prompt.

Automatic Chain-of-Thought (Auto-CoT)

When applying chain-of-thought prompting with demonstrations, the process involves hand-crafting effective and diverse examples. This manual effort could lead to suboptimal solutions. Zhang et al. (2022) propose an approach to eliminate manual efforts by leveraging LLMs with "Let's think step by step" prompt to generate reasoning chains for demonstrations one by one. This automatic process can still end up with mistakes in generated chains. To mitigate the effects of the mistakes, the diversity of demonstrations matter. This work proposes Auto-CoT, which samples questions with diversity and generates reasoning chains to construct the demonstrations.

Auto-CoT consists of two main stages:

-

Stage 1): question clustering: partition questions of a given dataset into a few clusters

-

Stage 2): demonstration sampling: select a representative question from each cluster and generate its reasoning chain using Zero-Shot-CoT with simple heuristics

The simple heuristics could be length of questions (e.g., 60 tokens) and number of steps in rationale (e.g., 5 reasoning steps). This encourages the model to use simple and accurate demonstrations.

The process is illustrated below:

Code for Auto-CoT is available here.

Dịch: Lê Trung Nghĩa

letrungnghia.foss@gmail.com

Tác giả: Nghĩa Lê Trung

Ý kiến bạn đọc

Những tin mới hơn

Những tin cũ hơn