Hướng dẫn kỹ thuật lời nhắc. Kỹ thuật viết lời nhắc. Tạo sinh Tăng cường Truy xuất (RAG)

Thứ bảy - 08/11/2025 06:23

Retrieval Augmented Generation (RAG)

Theo: https://www.promptingguide.ai/techniques/rag

Các mô hình ngôn ngữ mục đích chung có thể được tinh chỉnh để đạt được vài nhiệm vụ chung chẳng hạn như phân tích cảm xúc và nhận diện thực thể được đặt tên. Các nhiệm vụ đó thường không đòi hỏi kiến thức nền tảng bổ sung.

Đối với các tác vụ phức tạp và đòi hỏi nhiều kiến thức hơn, có thể xây dựng một hệ thống dựa trên mô hình ngôn ngữ, cho phép truy cập các nguồn kiến thức bên ngoài để hoàn thành tác vụ. Điều này cho phép tính nhất quán về dữ kiện cao hơn, cải thiện độ tin cậy của các phản hồi được tạo ra và giúp giảm thiểu vấn đề "ảo giác".

Các nhà nghiên cứu Meta AI đã giới thiệu một phương pháp gọi là Tạo sinh Tăng cường Truy xuất - RAG (Retrieval Augmented Generation) để giải quyết các tác vụ đòi hỏi nhiều kiến thức như vậy. RAG kết hợp một thành phần truy xuất thông tin với một mô hình tạo sinh văn bản. RAG có thể được tinh chỉnh và kiến thức nội bộ của nó có thể được sửa đổi một cách hiệu quả mà không cần phải đào tạo lại toàn bộ mô hình.

RAG lấy dữ liệu đầu vào và truy xuất một tập hợp các tài liệu liên quan/hỗ trợ dựa trên một nguồn (ví dụ: Wikipedia). Các tài liệu được nối theo ngữ cảnh với lời nhắc nhập ban đầu và được đưa vào trình tạo sinh văn bản, nơi tạo ra kết quả cuối cùng. Điều này làm cho RAG thích ứng với các tình huống mà dữ kiện có thể thay đổi theo thời gian. Điều này rất hữu ích vì kiến thức tham số của LLM là tĩnh. RAG cho phép các mô hình ngôn ngữ bỏ qua việc đào tạo lại, cho phép truy cập thông tin mới nhất để tạo sinh các đầu ra đáng tin cậy thông qua phương pháp tạo sinh dựa trên truy xuất.

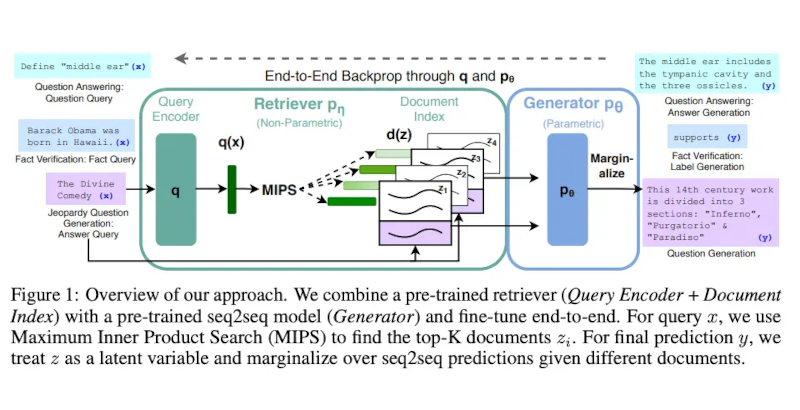

Lewis và cộng sự, (2021) đã đề xuất một công thức tinh chỉnh đa năng cho RAG. Một mô hình seq2seq được đào tạo trước được sử dụng làm bộ nhớ tham số và một chỉ mục vectơ dày đặc của Wikipedia được sử dụng làm bộ nhớ phi tham số (được truy cập bằng bộ truy xuất thần kinh được đào tạo trước). Dưới đây là tổng quan về cách thức hoạt động của phương pháp này:

Image Source: Lewis et el. (2021)

RAG hoạt động mạnh mẽ trên một số tiêu chuẩn như Natural Questions, WebQuestions và CuratedTrec. RAG tạo ra các câu trả lời thực tế, cụ thể và đa dạng hơn khi được kiểm tra trên các câu hỏi MS-MARCO và Jeopardy. RAG cũng cải thiện kết quả xác minh dữ kiện FEVER.

Điều này cho thấy tiềm năng của RAG như một lựa chọn khả thi để cải thiện kết quả của các mô hình ngôn ngữ trong các nhiệm vụ đòi hỏi kiến thức chuyên sâu.

Gần đây, các phương pháp tiếp cận dựa trên bộ truy xuất này đã trở nên phổ biến hơn và được kết hợp với các chương trình LLM phổ biến như ChatGPT để cải thiện khả năng và tính nhất quán của dữ kiện.

Trường hợp sử dụng RAG: Tạo sinh tiêu đề bài báo học máy thân thiện

Dưới đây, chúng tôi đã chuẩn bị một hướng dẫn sổ tay giới thiệu việc sử dụng các Mô hình Ngôn ngữ Lớn - LLM (Large Language Model) nguồn mở để xây dựng hệ thống RAG nhằm tạo sinh tiêu đề bài báo học máy ngắn gọn và súc tích:

Tài liệu tham khảo

-

Tạo sinh Tăng cường Truy xuất cho Mô hình Ngôn ngữ Lớn: Khảo sát (tháng 12 năm 2023)

-

Tạo sinh Tăng cường Truy xuất: Hợp lý hóa việc tạo lập các mô hình xử lý ngôn ngữ tự nhiên thông minh (tháng 9 năm 2020)

Về ‘Kỹ thuật viết lời nhắc’ ………. Phần trước ………. Phần tiếp theo

General-purpose language models can be fine-tuned to achieve several common tasks such as sentiment analysis and named entity recognition. These tasks generally don't require additional background knowledge.

For more complex and knowledge-intensive tasks, it's possible to build a language model-based system that accesses external knowledge sources to complete tasks. This enables more factual consistency, improves reliability of the generated responses, and helps to mitigate the problem of "hallucination".

Meta AI researchers introduced a method called Retrieval Augmented Generation (RAG) to address such knowledge-intensive tasks. RAG combines an information retrieval component with a text generator model. RAG can be fine-tuned and its internal knowledge can be modified in an efficient manner and without needing retraining of the entire model.

RAG takes an input and retrieves a set of relevant/supporting documents given a source (e.g., Wikipedia). The documents are concatenated as context with the original input prompt and fed to the text generator which produces the final output. This makes RAG adaptive for situations where facts could evolve over time. This is very useful as LLMs's parametric knowledge is static. RAG allows language models to bypass retraining, enabling access to the latest information for generating reliable outputs via retrieval-based generation.

Lewis et al., (2021) proposed a general-purpose fine-tuning recipe for RAG. A pre-trained seq2seq model is used as the parametric memory and a dense vector index of Wikipedia is used as non-parametric memory (accessed using a neural pre-trained retriever). Below is a overview of how the approach works:

RAG performs strong on several benchmarks such as Natural Questions, WebQuestions, and CuratedTrec. RAG generates responses that are more factual, specific, and diverse when tested on MS-MARCO and Jeopardy questions. RAG also improves results on FEVER fact verification.

This shows the potential of RAG as a viable option for enhancing outputs of language models in knowledge-intensive tasks.

More recently, these retriever-based approaches have become more popular and are combined with popular LLMs like ChatGPT to improve capabilities and factual consistency.

RAG Use Case: Generating Friendly ML Paper Titles

Below, we have prepared a notebook tutorial showcasing the use of open-source LLMs to build a RAG system for generating short and concise machine learning paper titles:

Dịch: Lê Trung Nghĩa

letrungnghia.foss@gmail.com

Tác giả: Nghĩa Lê Trung

Ý kiến bạn đọc

Những tin mới hơn

Những tin cũ hơn