AI data transparency: understanding the needs and current state of play

Có rất ít sự minh bạch về dữ liệu được sử dụng trong các hệ thống AI - một thực tế gây ra mối lo ngại gia tăng khi các hệ thống đó ngày càng được sử dụng với các hệ lụy của thế giới thực.

Mon Jun 24, 2024

Bài được đưa lên Internet ngày: 24/06/2024

Khi các hệ thống AI ngày càng được sử dụng trong công việc và cuộc sống hàng ngày, việc hiểu các khía cạnh chính cách các hệ thống đó đã được tạo ra như thế nào và tin tưởng các kết quả đầu ra xa đến thế nào đang ngày càng trở nên thiết yếu hơn.

Như chúng tôi đã viết trong một bài báo được xuất bản gần đây trên Harvard Business Review, các nguồn dữ liệu khổng lồ, khó sử dụng và mù mờ không rõ ràng được sử dụng như là cơ sở cho việc sản xuất các kết quả đầu ra của các hệ thống AI tạo sinh (Generative AI). Việc không ghi lại thành tài liệu một cách công khai các nội dung và việc sử dụng các tập dữ liệu cản trở khả năng của các nhà phát triển, các nhà nghiên cứu, các nhà đạo đức học, và các nhà hoạch định chính sách để giải quyết các vấn đề khác nhau như các thành kiến, nội dung độc hại, lo ngại về bản quyền, và các rủi ro cho dữ liệu cá nhân và dữ liệu nhạy cảm. Sự thiếu tài liệu này lan sang tất cả các yếu tố của dữ liệu, bao gồm cả các tệp dữ liệu đào tạo và tinh chỉnh, cũng như các quy trình xác định gốc gác và gắn nhãn.

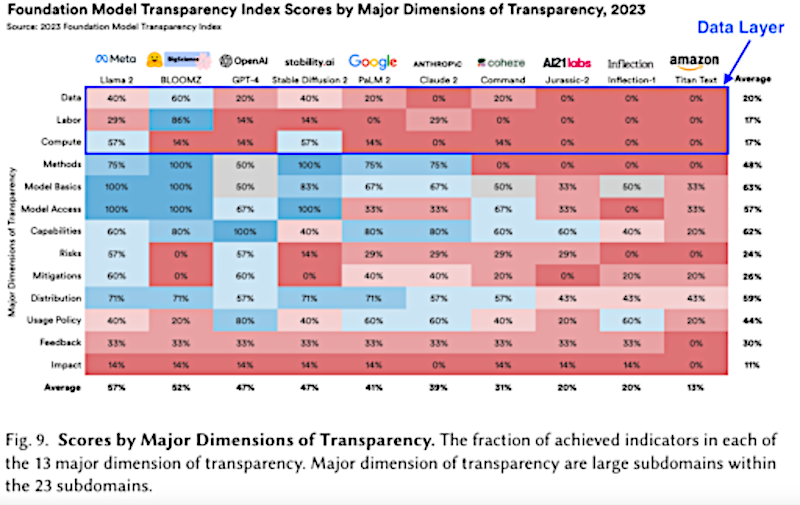

Trong bối cảnh cần minh bạch hơn trong thực hành dữ liệu AI, việc thiếu các phương pháp giám sát có hệ thống vẫn tồn tại trên nhiều hệ thống. Một nghiên cứu vào tháng 10 năm 2023 về 10 mô hình AI (“nền tảng”) chủ chốt của các nhà nghiên cứu Stanford đã nhấn mạnh rằng trong số các mô hình nói chung có tính minh bạch thấp khắp trong quá trình phát triển hệ thống AI, thì tính minh bạch về dữ liệu đặc biệt kém. Một bản cập nhật được phát hành gần đây cho nghiên cứu bao gồm một số mô hình khác và đã ghi nhận sự cải thiện nhỏ của một số nhà phát triển, nhưng nhìn chung, tính minh bạch dữ liệu vẫn còn kém.

Trong một nghiên cứu sắp tới của các thành viên trong nhóm nghiên cứu AI lấy dữ liệu làm trung tâm (Data-centric AI) của chúng tôi, chúng tôi đã sao chép phân tích trên phạm vi rộng hơn gồm 54 hệ thống AI đang gây lo ngại cho công chúng, vốn là trung tâm của các sự cố AI được ghi lại trong Cơ sở dữ liệu sự cố AI của Quan hệ đối tác AI. Chúng tôi nhận thấy rằng chỉ một số ít các hệ thống AI này cung cấp thông tin có thể nhận dạng được về các mô hình cơ bản và cách thực hành dữ liệu của chúng. Điểm số về tính minh bạch (được đánh giá cho những hệ thống cung cấp thông tin về tính minh bạch của mô hình cơ bản) ở mức thấp trên tất cả các chỉ số bao gồm kích thước dữ liệu, nguồn và giám tuyển dữ liệu, với từng chỉ số hiện diện trong ít hơn 40% mô hình được đánh giá. Hầu như không có hệ thống nào ghi điểm bao gồm thông tin về việc đưa dữ liệu có bản quyền, thông tin cá nhân trong dữ liệu hoặc việc sử dụng giấy phép dữ liệu.

Để dựa trên những phát hiện của mình, chúng tôi đang phát triển chỉ số minh bạch dữ liệu AI để cung cấp bức tranh rõ ràng hơn về mức độ minh bạch dữ liệu khác nhau giữa các loại nhà cung cấp hệ thống khác nhau, dựa trên sự hiểu biết sâu sắc hơn về nhu cầu đối với thông tin đó. Việc điều tra nhu cầu minh bạch dữ liệu trong hệ sinh thái sẽ dựa trên bằng chứng hiện tại, bao gồm cả nghiên cứu Tương lai mở gần đây về tài liệu minh bạch. Nghiên cứu sâu hơn sẽ tập trung vào việc trao quyền cho những người không chuyên và các cộng đồng bằng thông tin minh bạch, đồng thời hiểu rõ các rào cản và cơ hội để những người thực hành AI truyền đạt tính minh bạch của dữ liệu một cách hiệu quả.

Mặc dù tính minh bạch không thể được coi là “viên đạn bạc” để giải quyết các thách thức về đạo đức liên quan đến hệ thống AI hoặc xây dựng lòng tin, nhưng đó là điều kiện tiên quyết để đưa ra quyết định sáng suốt và các hình thức can thiệp khác như các quy định. Nếu bạn quan tâm đến việc cộng tác với chúng tôi trong nghiên cứu và vận động đang diễn ra của chúng tôi trong lĩnh vực này hoặc muốn thảo luận thêm về công việc này, vui lòng liên hệ.

There is very little transparency about the data used in AI systems - a fact that is causing growing concern as these systems are increasingly deployed with real-world consequences.

As AI systems become increasingly used in everyday work and life, understanding key aspects of how these systems have been created and how far to trust the outcomes is becoming more and more essential.

As we outline in an article we recently published in the Harvard Business Review, enormous, unwieldy and opaque data sources are used as the basis for producing the generative AI systems’ outcomes. The failure to publicly document the contents and usage of datasets hampers the ability of developers, researchers, ethicists, and lawmakers to address various issues such as biases, harmful content, copyright concerns, and risks to personal or sensitive data. This lack of documentation spans all data elements, including training and fine-tuning datasets, as well as the sourcing and labelling processes.

The demand for AI transparency has become increasingly recognised in recent years. This has led to parts of the AI community making significant progress and contributions to AI data transparency, including the increasing emergence and uptake of standardised transparency guidelines. For example, but not limited to, Hugging Face, a vast repository of AI models and datasets, promoting the use of Model Cards and Dataset Cards to its community of developers. In another example, the Croissant initiative, supported by major platforms like Tensorflow and Hugging Face, provides machine-readable metadata (information about the datasets) for machine learning (ML) datasets, improving their accessibility, discoverability, and reproducibility and also helping to improve the management and accountability of work with the datasets by AI practitioners. All these resources guide developers on documenting how a model dataset was created and what it contains as well as potential legal or ethical issues to consider when working with it. Lawmakers are also responding to increasing demands by proposing legislation that specifically addresses AI data transparency - a topic we discuss further in our first policy position (of five we will publish in total) on what is needed to build the strong data infrastructure needed to realise responsible AI.

Amidst the need for greater transparency in AI data practices, a lack of systematic monitoring methods persists across many systems. An October 2023 study of 10 key generative AI (‘foundation’) models by Stanford researchers highlighted that among general low transparency across AI system development, transparency about data is particularly poor. A recently released update to the study included several more models and noted slight improvement by some developers, but overall, there is still poor data transparency.

In a forthcoming study by members of our data-centric AI research team, we replicated the analysis on a wider range of 54 AI systems that are causing public concern, having been at the centre of AI incidents recorded in the Partnership of AI's AI Incidents Database. We found that only a minority of these AI systems provided identifiable information about their underlying models and data practices. Transparency scores (evaluated for those systems offering basic model transparency information) were low across all indicators including data size, data sources and curation, with each indicator present in less than 40% of the models evaluated. Almost none of the systems scored included information about the inclusion of copyrighted data, personal information in data, or the use of data licences.

To build on our findings, we are developing an AI data transparency index to provide a clearer picture of how data transparency varies across different types of system providers, based on a deeper understanding of the needs for such information. Investigating the need for data transparency within the ecosystem will build on current evidence, including recent Open Futures research on transparency documentation. Further research will focus on empowering non-specialists and communities with transparency information, and on understanding the barriers and opportunities for AI practitioners to communicate data transparency effectively.

While transparency cannot be considered a ‘silver bullet’ for addressing the ethical challenges associated with AI systems, or building trust, it is a prerequisite for informed decision-making and other forms of intervention like regulation. If you are interested in collaborating with us on our ongoing research and advocacy in this area or would like to discuss this work further, please get in touch.

Dịch: Lê Trung Nghĩa

letrungnghia.foss@gmail.com

Tác giả: Nghĩa Lê Trung

Ý kiến bạn đọc

Những tin mới hơn

Những tin cũ hơn

Blog này được chuyển đổi từ http://blog.yahoo.com/letrungnghia trên Yahoo Blog sang sử dụng NukeViet sau khi Yahoo Blog đóng cửa tại Việt Nam ngày 17/01/2013.Kể từ ngày 07/02/2013, thông tin trên Blog được cập nhật tiếp tục trở lại với sự hỗ trợ kỹ thuật và đặt chỗ hosting của nhóm phát triển...

DigComp 3.0: Khung năng lực số châu Âu

DigComp 3.0: Khung năng lực số châu Âu

Các bài toàn văn trong năm 2025

Các bài toàn văn trong năm 2025

Các bài trình chiếu trong năm 2025

Các bài trình chiếu trong năm 2025

Các lớp tập huấn thực hành ‘Khai thác tài nguyên giáo dục mở’ tới hết năm 2025

Các lớp tập huấn thực hành ‘Khai thác tài nguyên giáo dục mở’ tới hết năm 2025

Tập huấn thực hành ‘Khai thác tài nguyên giáo dục mở’ cho giáo viên phổ thông, bao gồm cả giáo viên tiểu học và mầm non tới hết năm 2025

Tập huấn thực hành ‘Khai thác tài nguyên giáo dục mở’ cho giáo viên phổ thông, bao gồm cả giáo viên tiểu học và mầm non tới hết năm 2025

Các tài liệu dịch sang tiếng Việt tới hết năm 2025

Các tài liệu dịch sang tiếng Việt tới hết năm 2025

Loạt bài về AI và AI Nguồn Mở: Công cụ AI; Dự án AI Nguồn Mở; LLM Nguồn Mở; Kỹ thuật lời nhắc;

Loạt bài về AI và AI Nguồn Mở: Công cụ AI; Dự án AI Nguồn Mở; LLM Nguồn Mở; Kỹ thuật lời nhắc;

Tổng hợp các bài của Nhóm các Nhà cấp vốn Nghiên cứu Mở (ORFG) đã được dịch sang tiếng Việt

Tổng hợp các bài của Nhóm các Nhà cấp vốn Nghiên cứu Mở (ORFG) đã được dịch sang tiếng Việt

Tổng hợp các bài của Liên minh S (cOAlition S) đã được dịch sang tiếng Việt

Tổng hợp các bài của Liên minh S (cOAlition S) đã được dịch sang tiếng Việt

Năm Khoa học Mở & Chuyển đổi sang Khoa học Mở - Tổng hợp các bài liên quan

Năm Khoa học Mở & Chuyển đổi sang Khoa học Mở - Tổng hợp các bài liên quan

Bàn về 'Lợi thế của doanh nghiệp Việt là dữ liệu Việt, bài toán Việt' - bài phát biểu của Bộ trưởng Nguyễn Mạnh Hùng ngày 21/08/2025

Bàn về 'Lợi thế của doanh nghiệp Việt là dữ liệu Việt, bài toán Việt' - bài phát biểu của Bộ trưởng Nguyễn Mạnh Hùng ngày 21/08/2025

‘KHUYẾN NGHỊ VÀ HƯỚNG DẪN TRUY CẬP MỞ KIM CƯƠNG cho các cơ sở, nhà cấp vốn, nhà bảo trợ, nhà tài trợ, và nhà hoạch định chính sách’ - bản dịch sang tiếng Việt

‘KHUYẾN NGHỊ VÀ HƯỚNG DẪN TRUY CẬP MỞ KIM CƯƠNG cho các cơ sở, nhà cấp vốn, nhà bảo trợ, nhà tài trợ, và nhà hoạch định chính sách’ - bản dịch sang tiếng Việt

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm)

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm)

‘Đặc tả Khung Tính mở Mô hình (MOF)’ của LF AI & Data - Tài sản chung của AI Tạo sinh - bản dịch sang tiếng Việt

‘Đặc tả Khung Tính mở Mô hình (MOF)’ của LF AI & Data - Tài sản chung của AI Tạo sinh - bản dịch sang tiếng Việt

‘LỘ TRÌNH CỦA TỔNG THƯ KÝ LIÊN HIỆP QUỐC VỀ HỢP TÁC KỸ THUẬT SỐ THÚC ĐẨY HÀNG HÓA CÔNG CỘNG KỸ THUẬT SỐ’ - bản dịch sang tiếng Việt

‘LỘ TRÌNH CỦA TỔNG THƯ KÝ LIÊN HIỆP QUỐC VỀ HỢP TÁC KỸ THUẬT SỐ THÚC ĐẨY HÀNG HÓA CÔNG CỘNG KỸ THUẬT SỐ’ - bản dịch sang tiếng Việt

AI trong TVET - Một vài gợi ý triển khai trong thực tế

AI trong TVET - Một vài gợi ý triển khai trong thực tế

Tọa đàm ‘Vai trò của Tài nguyên Giáo dục Mở trong chuyển đổi số giáo dục đại học’ tại Viện Chuyển đổi số và Học liệu - Đại học Huế, ngày 12/09/2025

Tọa đàm ‘Vai trò của Tài nguyên Giáo dục Mở trong chuyển đổi số giáo dục đại học’ tại Viện Chuyển đổi số và Học liệu - Đại học Huế, ngày 12/09/2025

‘Hiệp ước Kỹ thuật số Toàn cầu’ của Liên hiệp quốc - bản dịch sang tiếng Việt

‘Hiệp ước Kỹ thuật số Toàn cầu’ của Liên hiệp quốc - bản dịch sang tiếng Việt

12 dự án AI Nguồn Mở hàng đầu để bổ sung vào kho công nghệ của bạn. 11. Hugging Face Transformers

12 dự án AI Nguồn Mở hàng đầu để bổ sung vào kho công nghệ của bạn. 11. Hugging Face Transformers

Dự án DIAMAS đưa ra Khuyến nghị và Hướng dẫn Truy cập Mở Kim cương

Dự án DIAMAS đưa ra Khuyến nghị và Hướng dẫn Truy cập Mở Kim cương

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm) - Trợ lý AI tốt nhất (chatbots)

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm) - Trợ lý AI tốt nhất (chatbots)

Hướng dẫn kỹ thuật lời nhắc. Kỹ thuật viết lời nhắc. Lời nhắc Tái Hành động (ReAct)

Hướng dẫn kỹ thuật lời nhắc. Kỹ thuật viết lời nhắc. Lời nhắc Tái Hành động (ReAct)

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm) - Trình tạo nhạc AI tốt nhất

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm) - Trình tạo nhạc AI tốt nhất

Nâng cao tính mở và khả năng sử dụng của Hàng hóa Công cộng Kỹ thuật số bằng cách chỉ chấp nhận các bộ sưu tập nội dung và bộ dữ liệu hoàn toàn được cấp phép mở

Nâng cao tính mở và khả năng sử dụng của Hàng hóa Công cộng Kỹ thuật số bằng cách chỉ chấp nhận các bộ sưu tập nội dung và bộ dữ liệu hoàn toàn được cấp phép mở

Vì sao Singapore đang xây dựng hàng hóa công cộng kỹ thuật số

Vì sao Singapore đang xây dựng hàng hóa công cộng kỹ thuật số

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm) - Công cụ AI quản lý kiến thức tốt nhất

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm) - Công cụ AI quản lý kiến thức tốt nhất

Hiểu các giấy phép CC và đào tạo AI: Một tóm tắt về pháp lý

Hiểu các giấy phép CC và đào tạo AI: Một tóm tắt về pháp lý

Chiến lược 2023-2028 của DPGA

Chiến lược 2023-2028 của DPGA

Hướng dẫn nghiên cứu của khoa về ChatGPT và các công cụ AI

Hướng dẫn nghiên cứu của khoa về ChatGPT và các công cụ AI

Các công cụ pháp lý CC được thừa nhận là Hàng hóa Công cộng Kỹ thuật số

Các công cụ pháp lý CC được thừa nhận là Hàng hóa Công cộng Kỹ thuật số